现在在硅谷,几乎每一家值得一提的科技公司都有一个虚拟助手:苹果的Siri,亚马逊的Alexa,微软的Cortana,谷歌的Google Assistant等等。这些数字化助手(被称为聊天机器人)会给我们带来哪些惊喜呢?

近日,《科学》杂志采访了一位从事人机对话研究的专家,他就是卡内基梅隆大学的计算机科学家Alexander Rudnicky。这次采访探讨了聊天机器人能做什么,不能做什么,它们怎样向人类学习,以及是否可以阻止他们模仿人类的一些坏行为。

问:首先,问一个很基本的问题,什么是聊天机器人?

答:最初,聊天机器人是指可以通过文字或语言与人类进行某种有目的的互动系统。在学术界,“聊天”一词用来指代非目的导向(non–goal-directed)的互动,就像两个人在聚会上的闲聊一样。

问:聊天机器人是如何向人类学习的?

答:计算机首先需要清楚它遇到了问题,然后它要学会怎样把遇到的问题正确地表述出来。其实,你可以将其视为一种主动学习的形式,也就是交互。这样,就是在模拟人类之间相互学习的方式。

问:聊天机器人可不可以通过其他方式主动向我们学习?

答:他们也可以用实验的方式。比如,如果我在聊天中东拉西扯,而你开始听得心不在焉,那我必须改变我的讲话方式才能重新抓住你的注意力。同样,也可以赋予机器人评估对话参与度的能力,然而,它必须采用一定的策略才能抓住你的注意力。

为此,它可能学会向你大喊大叫。也许这听起来并不是一个好主意。但是,要知道,它可以尝试很多种其他的方式。

问:Siri和Alexa是如何做到上面所说的这些的?

答:其实,我认为Siri并不是严格意义上的聊天系统。 我更倾向于称它为信息存储与检索系统。它可以帮你联系通讯录中的联系人,告诉你天气怎样,或者该怎样去某个地方。

程序员也的确做了一些聪明的事情,比如说把类似于“你会嫁给我吗”这样的问题的答案内置在系统中,如果系统中有数以百计的类似问题的答案,人们就会认为,“哇,她真的很真实哎!”Alexa还有更多的花样,但是基本上都是一回事。

问:在创建聊天机器人时面临的最大挑战是什么?

答:以前,开发人员必须穷举出讲一句话时所有的表述方式,在很长一段时间里,这就是一个很大的障碍。最近的系统则使用所谓的“意图识别”(intent recognition)来获得某人所说内容的底层含义。这种技术是使用词义联想的方式,找到已知的最接近的表达方式,然后据此做出回应。

还有另一个挑战,是赋予机器人利用上下文和背景知识的能力。比如,如果我问机器人,“嘿,我想和我的朋友一起出去吃个饭”,我所说的话没有任何意义,这时,系统必须能意识到:“我应该告诉这个人,我不明白他讲的是什么意思。”

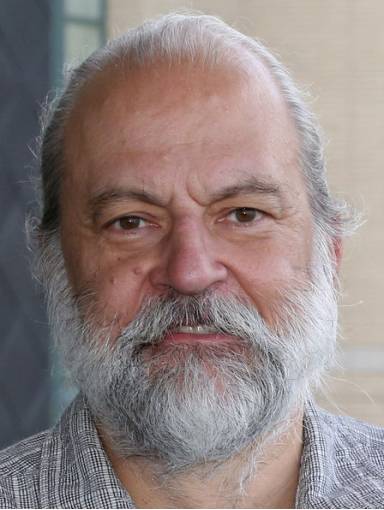

图 | Alexander Rudnicky

问:如何才能避免出现像微软的Tay那样富有攻击性的聊天机器人呢?您知道,它开始效仿Twitter用户的种族主义和反犹太主义情绪。

答:对研究“向人类学习的机器人”来说,那是个很好的案例。显然,人们开始在某些方面误导机器人。可以想象,如果没有误导的事情,对于机器人来说可能更好。但是,另一方面,当人们想要制造问题时,却真的很有创意。所以说,我也不知道它是否可控。

问:那么,在你自己的研究中,你想解决什么问题?

答:我来给你描述一个项目吧。现在,人们利用智能手机做各种各样复杂的事情。他们可能同时使用多个应用程序。

比如,如果你问某人在做什么,他可能会告诉你,“我正计划晚上和朋友出去,所以我要浏览一下餐厅和表演的信息,反复给朋友发信息确认,看看地图,诸如此类的。”

设想一下,如果聊天机器人可以注意到你在利用不同的应用程序做一件目的明显的事情,它会询问你在做什么,然后逐渐开始帮助你从繁琐的事项中解脱出来,这不是很有趣吗?

或者说至少是很有用的。等到下次你再说“我想组织晚上聚餐”时,至少,它能够知道应该为你显示哪些应用程序。而更复杂的任务则要求它将信息从一个应用程序传递到另一个应用程序。例如,它可能要将餐厅信息以短信形式发送给你的朋友们。

问:有没有可能让不同的聊天机器人把他们已有的知识结合起来?

答:在某种程度上说,这是关于标准的问题。各种聊天机器人需要在“知识的表征”上达成共识,“知识的表征”也就是我们称其为知识本体的东西。如果这样的话,那么原则上是可以做到你所说的那种共享的。但是,共享知识存在严重的隐私问题。如果我一直使用同一款聊天机器人,那么它将会很了解我,了解我的朋友,知道我喜欢什么样的食物。也许我不会在乎这些个人信息,但也许它还会知道其他我绝不希望别人知道的隐私。

问:你是否担心人们会不信任这些聊天机器人,因为它们虽然和人类很像但是又不足够像,也就是机器人研究人员称之为“恐怖谷”的问题?

答:生活中我们可能会遇到一些很奇怪的人。他们并不完全遵循惯例或交互规则。他们总是出乎我们的意料,这是有些令人不安的。而所谓的“恐怖谷”(当机器人与人类相似程度超过一定程度的时候,人类对其反应便会突然变得极为反感),基本上是当你的模型不够好,但却勉强通过测试时才会发生的。本质上说,这没什么意义,倒不如说那只是系统的一个缺点而已。

问:那么,Alexa何时才能最终显得真实呢?

答:对我来说,显得真实需要一个具有更好的语境意识的系统,例如它应该懂得不要不合时宜地提供服务或谈论很显而易见的内容,而且应该有更强的内省意识,也就是说要清楚自己何时遇到了问题,接受这一点,并且学会征求意见。

-End-

编辑:张洁

参考:

http://www.sciencemag.org/news/2017/06/when-will-alexa-google-assistant-and-other-chatbots-finally-talk-us-real-people?from=groupmessage&isappinstalled=0

《麻省理工科技评论》

2017年“全球50大最聪明的公司”榜单发布会

时间:6月27日

地点:北京· 国贸大酒店

报名方式:查看“阅读原文”返回搜狐,查看更多

责任编辑: